来自https://www.bilibili.com/video/BV17t4218761/ 的视频笔记,用于帮助自己快速了解和上手大模型

AIGC

AI Generated Content:

- 文本

- 代码

- 图片

- 音频

- 视频

生成式AI(Generated AI)—生成—> AIGC

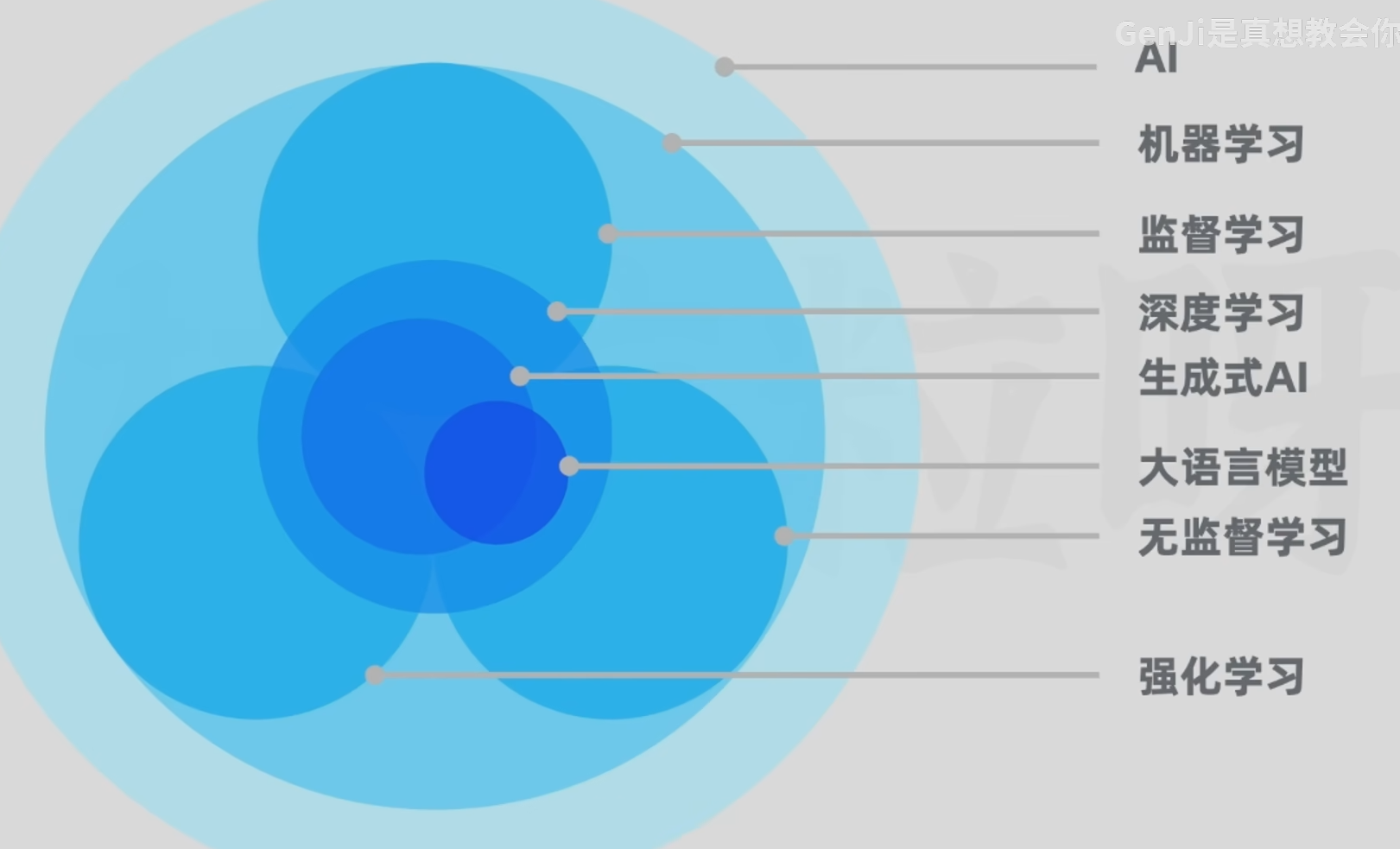

关系:

生成式AI:是深度学习的一种应用,它利用神经网络来识别现有内容的模式和结构,学习和生成新的内容

大语言模型(LLM):也是深度学习的一种应用,专门用于进行自然语言处理任务。

大:1)参数庞大 2)所需高质量训练数据大

图像生成:属于生成式AI但不是大语言模型

BERT:属于大语言模型但不是生成式AI(主要用于搜索(排名、信息摘录准确性)、情感分析、文本分类、命名实体识别),不擅长文本生成

大语言模型

Large Language Model

- 生成

- 分类

- 总结

- 改写

参数数量:GPT1(1.17亿);GPT2(15亿);GPT3(1750亿)

Attention Is All You Need -> 提出Transformer架构

GPT(Generative Pre-trained Transformer):生成式预训练Transformer

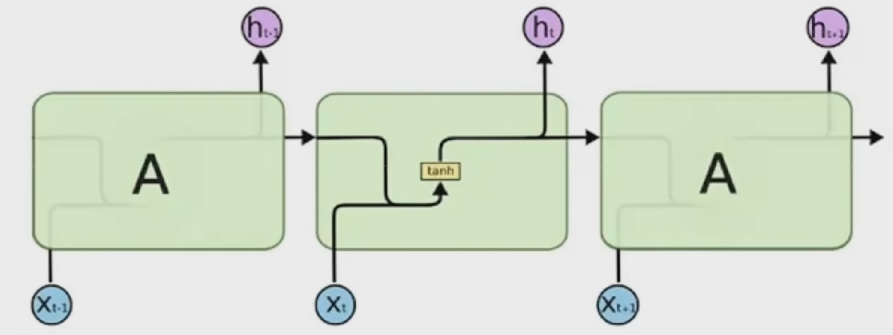

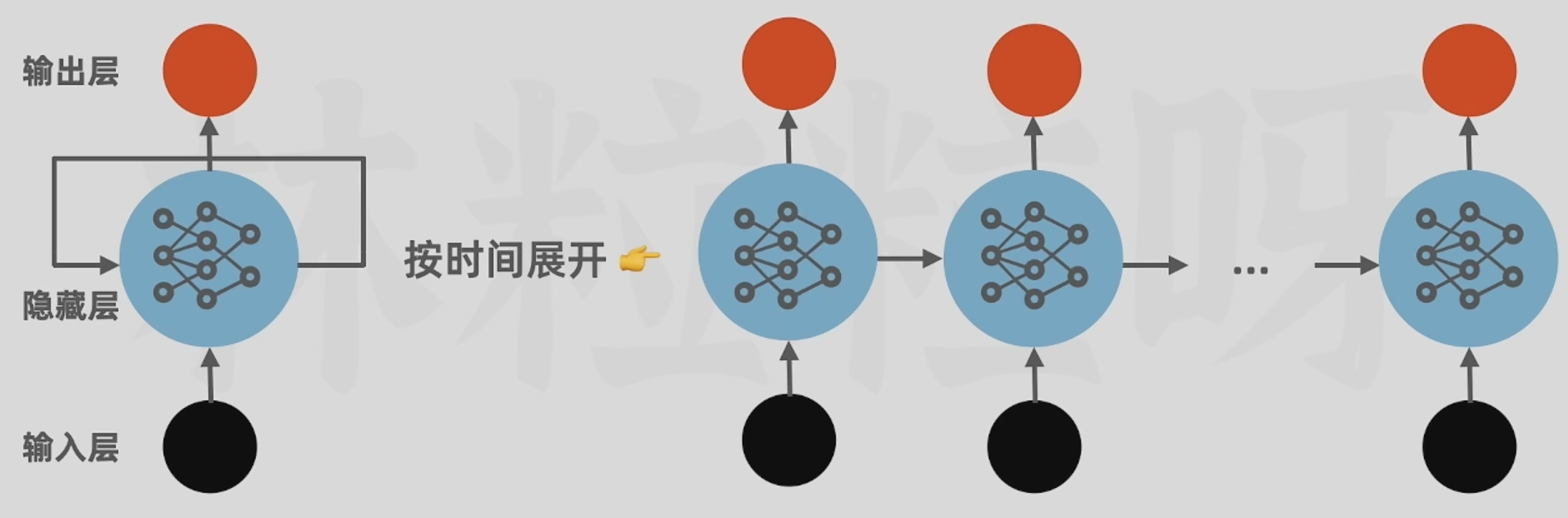

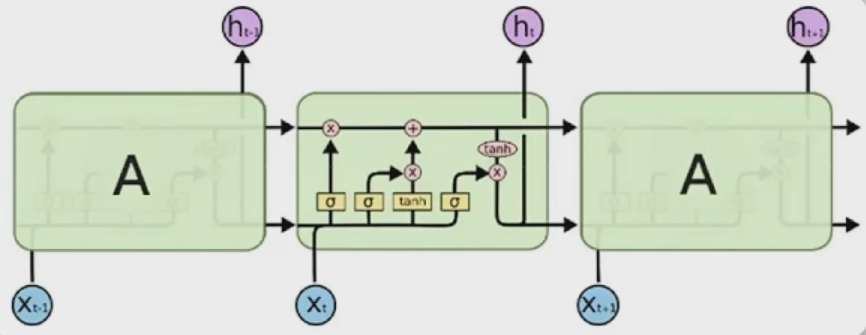

RNN:循环神经网络 按顺序逐字处理

难以有效捕获到长距离的语义关系

LSTM(长短期记忆网络):弥补RNN对长距离依赖性方面的不足

无法解决传统RNN无法并行计算的问题

Transformer:

- 自注意力机制:使之有能力学习输入序列里所有词的相关性和上下文,不会受到短时记忆的影响

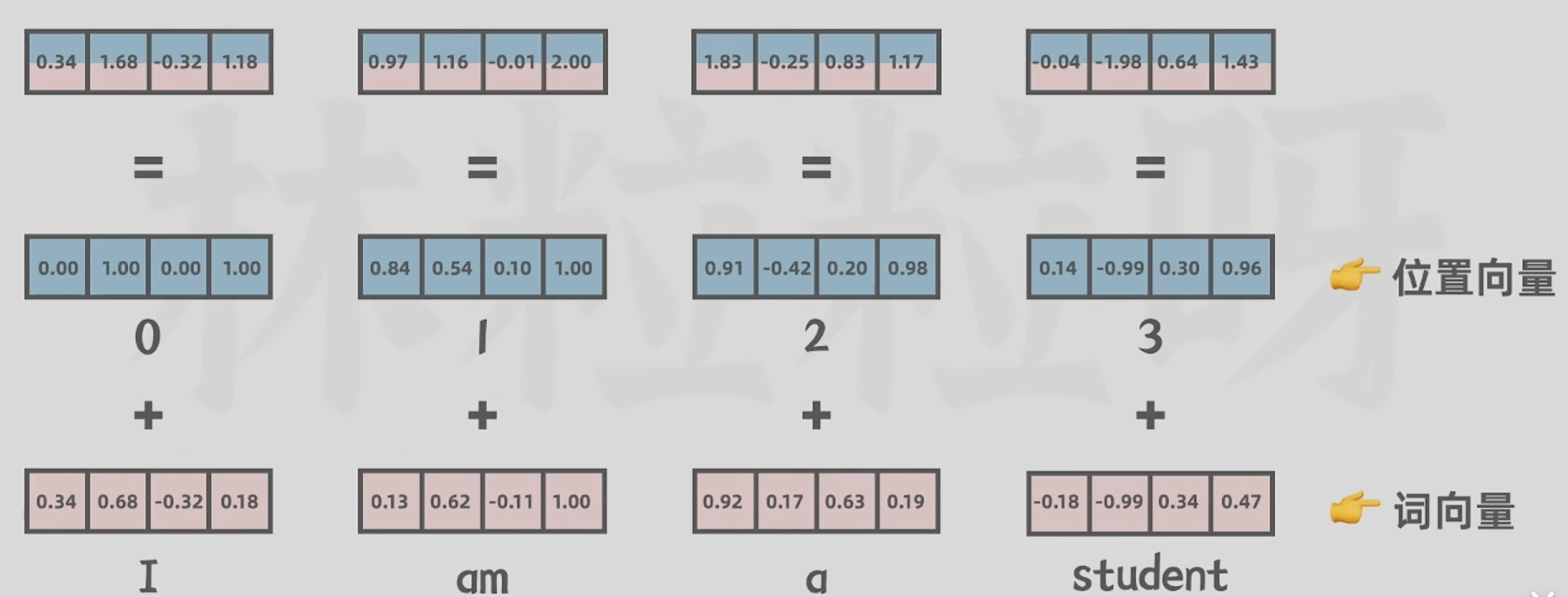

- 位置编码:词 -> 词向量(意义);词的位置 -> 位置向量(位置);汇总后输入神经网络 -> 词可以不按顺序输入 -> 实现并行

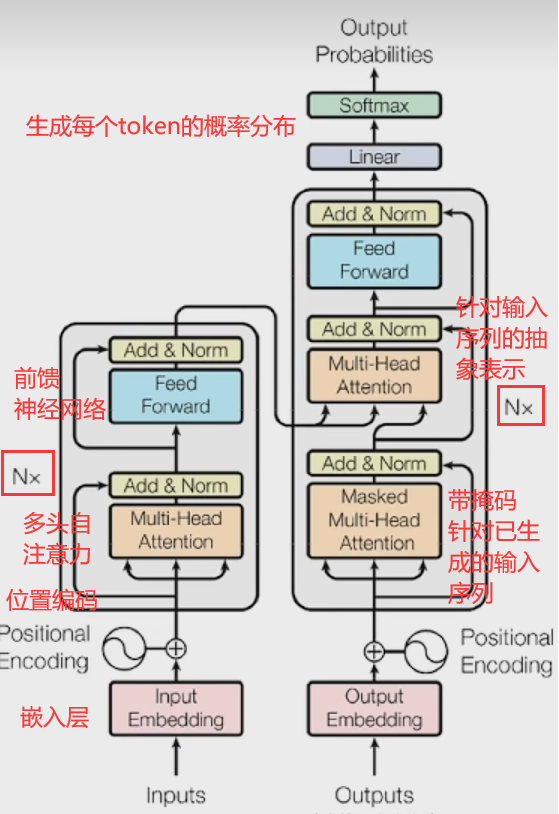

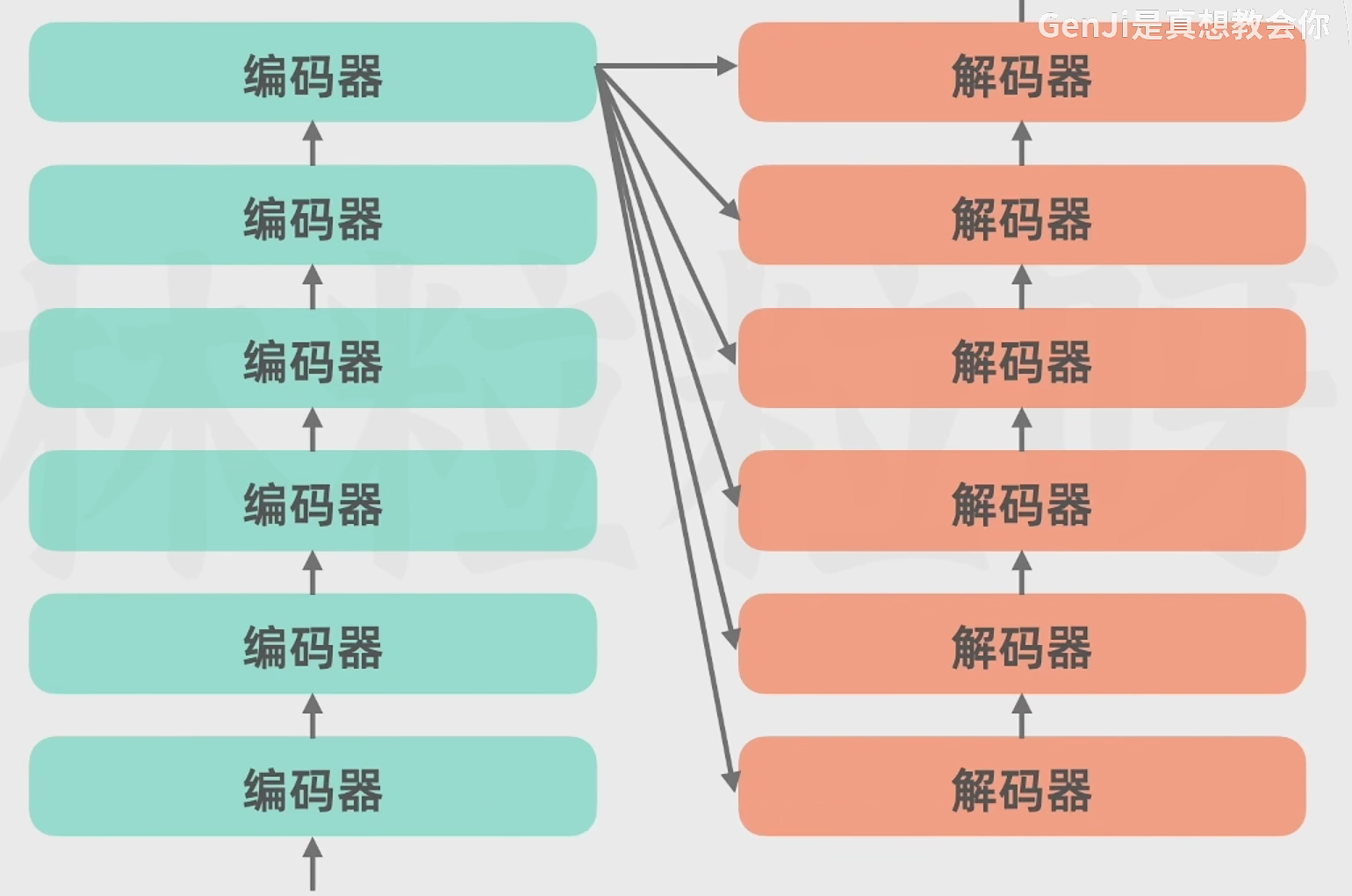

Transformer

- 编码器(Encoder)

- 解码器(Decoder)

过程:

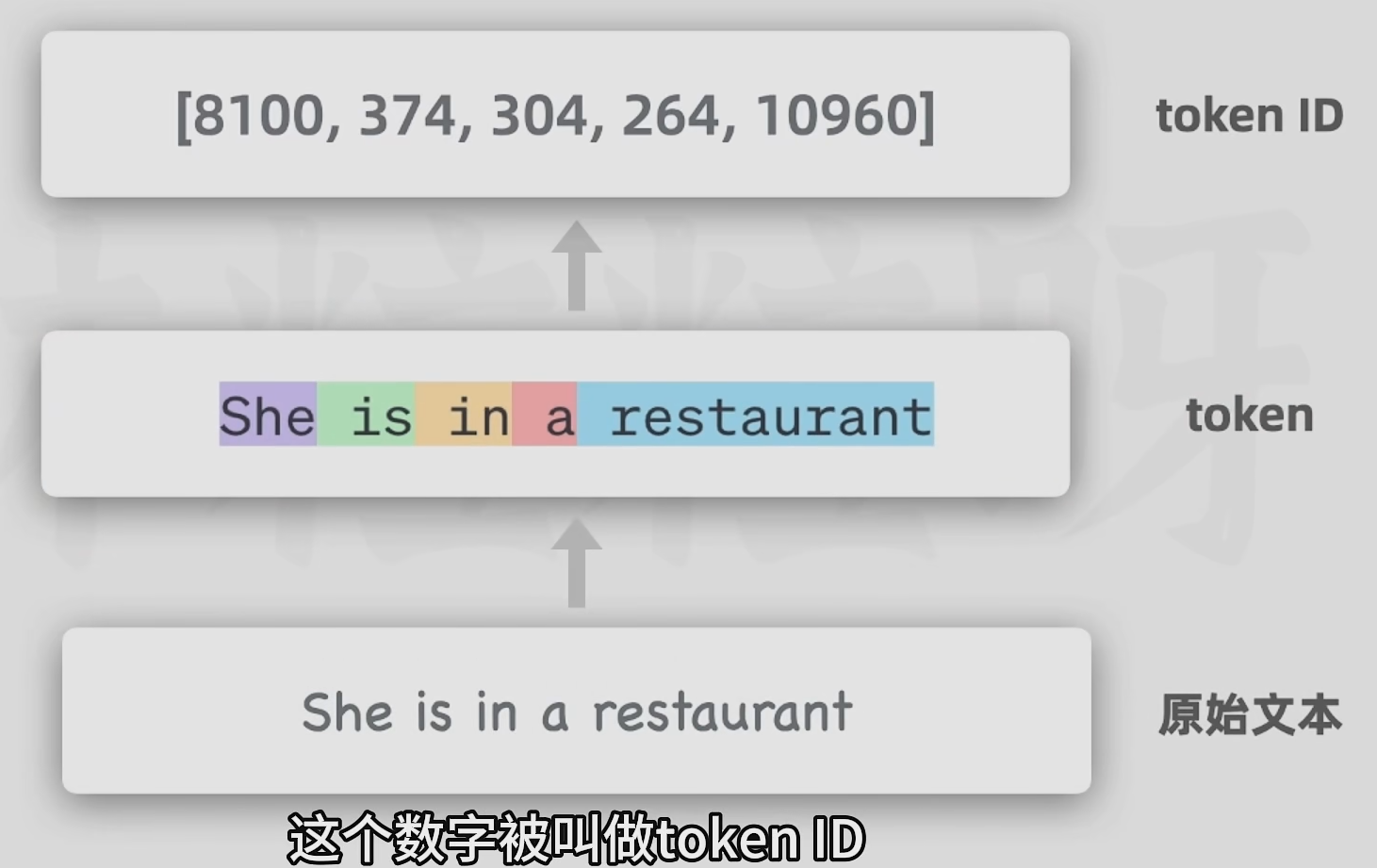

- 原始文本 -> 拆分为token(短单词为1个token,长单词可能被划分为多个token)-> token ID(整数数字)

- 向量嵌入(一个数字 -> 多个数字表示)

词向量 -> 不仅可以帮助模型理解词的语义,也可以帮助模型理解,也可以捕捉词与词之间的复杂关系

- 位置编码

- 编码器(自注意力机制)

多头自注意力:

每个头都有它自己的注意力权重,用来关注文本里不同特征或方面,可做并行运算

- 解码器

解码器不仅会接收来自编码器的输入序列的抽象表示作为输入,还会把之前已经生成的文本也作为输入,来保持输出的连贯性和上下文相关性

带掩码的多头自注意力机制(masked):(针对已生成的输出序列)

架构:

- linear和softmax层

将解码器的输出转化为词汇表的概率分布(代表下一个被生成token的概率)

Hallucination(幻觉):模型一本正经的胡说八道

三个类别:

- 仅编码器/自编码模型:BERT(掩码语言建模、情感分析等)

- 仅解码器/自回归模型:GPT2、GPT3(文本生成)

- 编码器 - 解码器/序列到序列模型:T5、BART(翻译、总结)

训练过程

- 无监督预训练:通过海量文本进行无监督学习 得到能进行文本生成的基座模型(最耗时烧钱的)

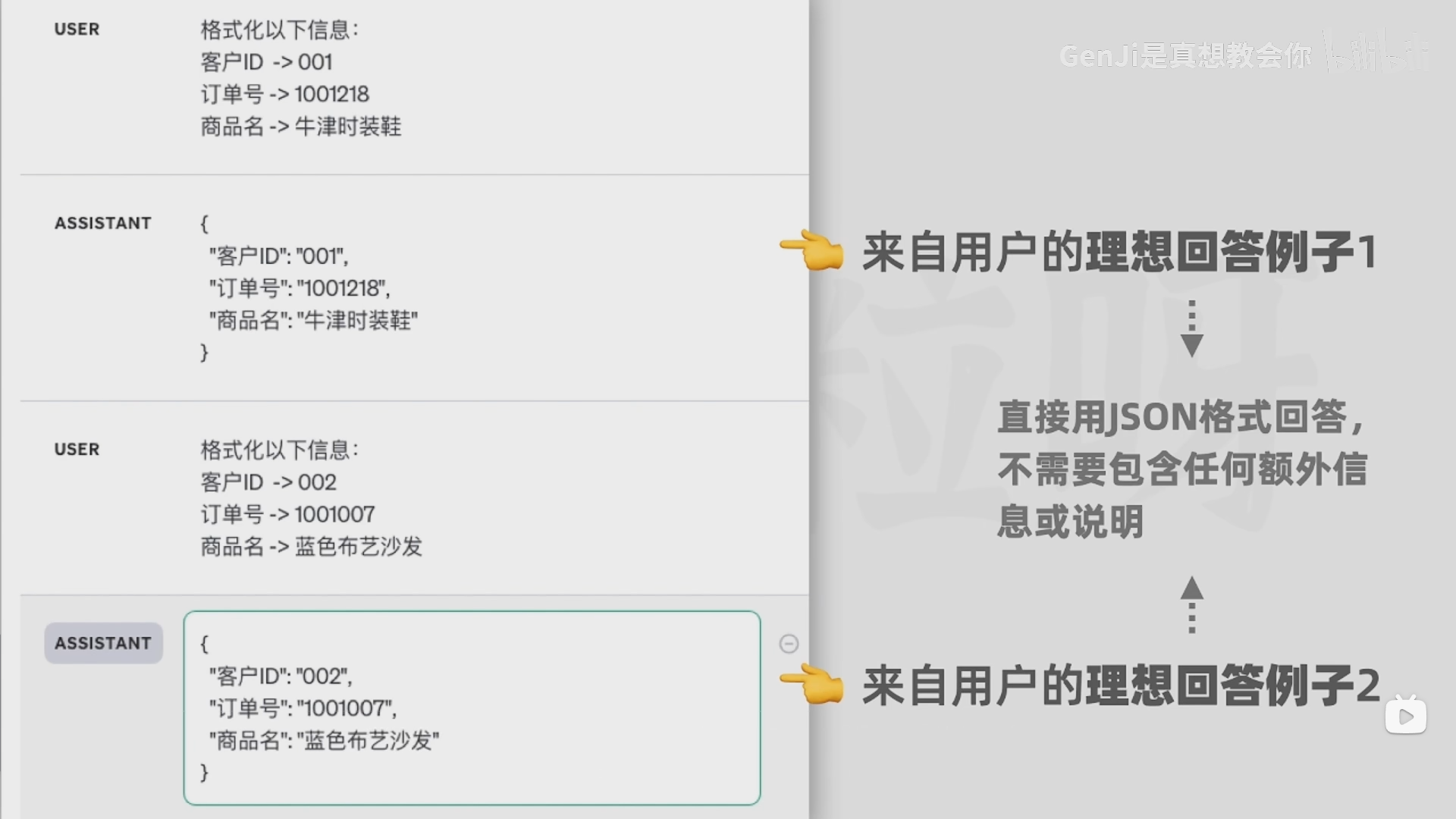

- 监督微调(Supervised Fine-Tuning,SFT):通过人类撰写的高质量对话数据,对基座模型进行监督微调,得到一个微调后的模型(除续写文本外,模型也会具备更好的对话能力)

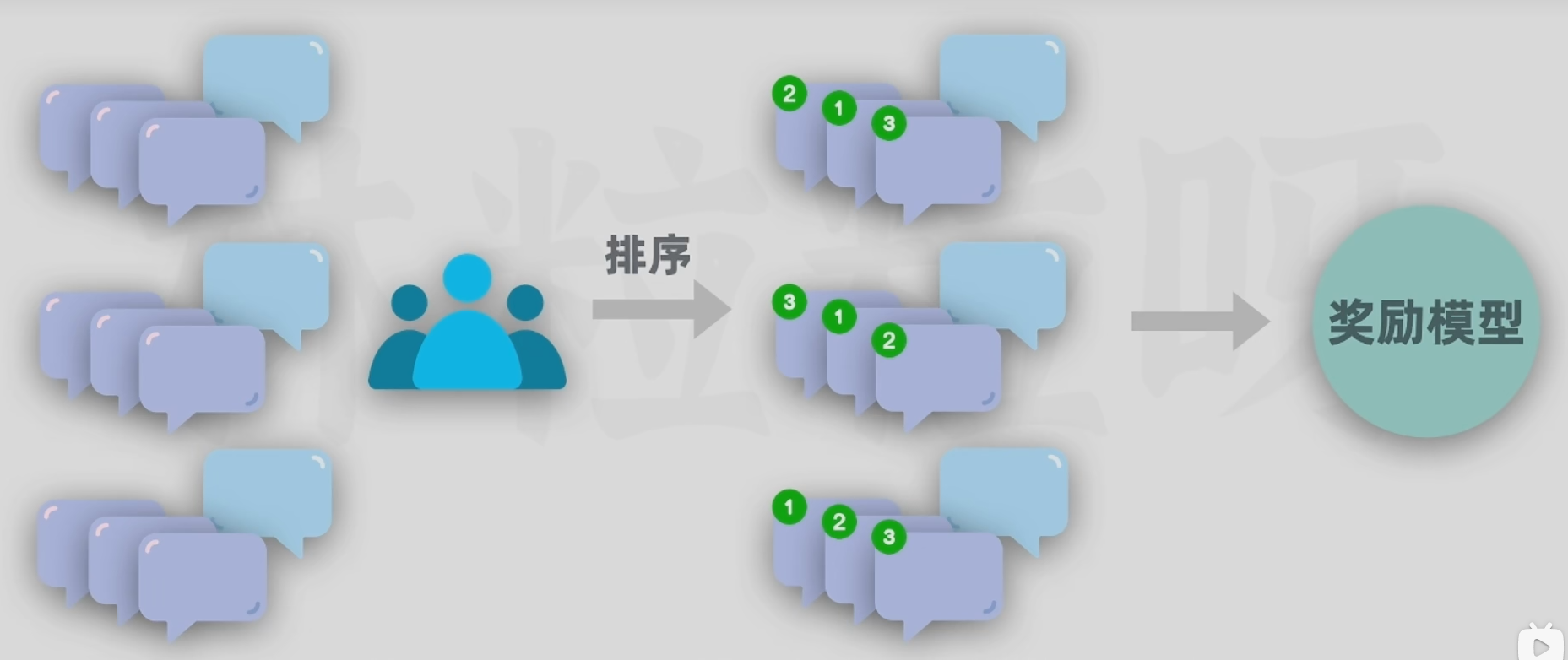

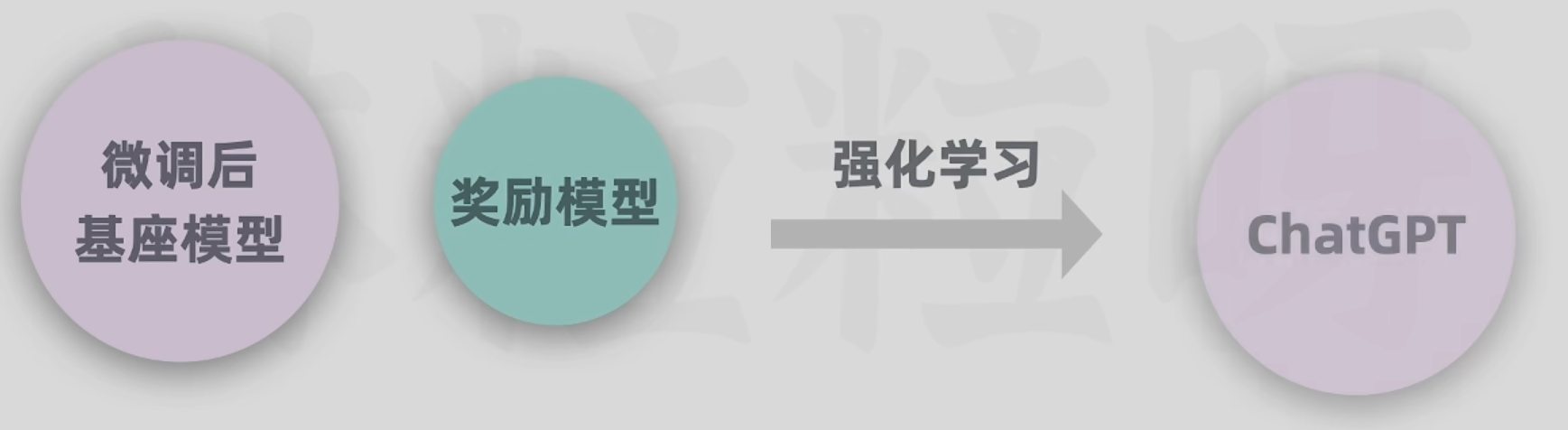

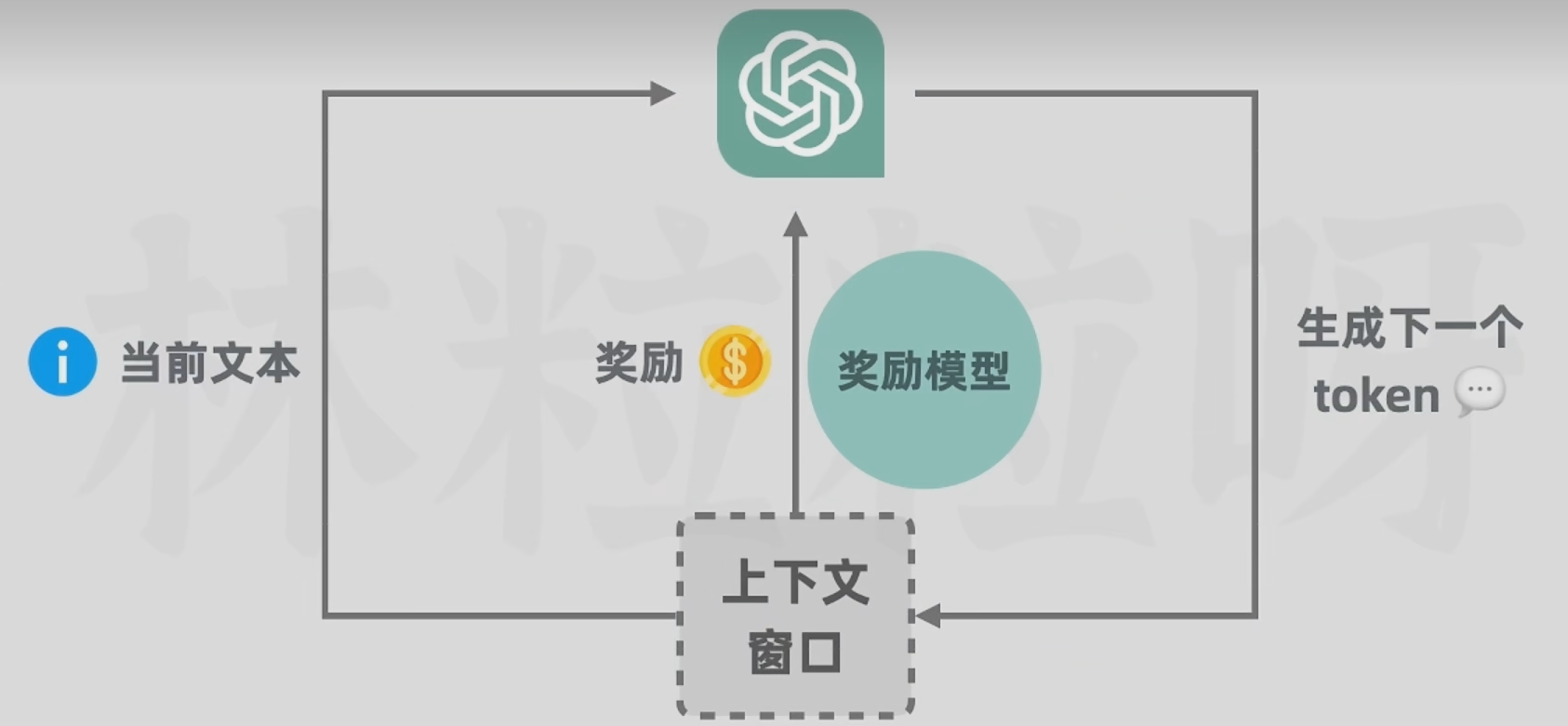

- 训练奖励模型 + 强化学习训练:用问题和多个对应回答的数据,让人类标注员对回答进行质量排序(3H原则:Helpful有用性、Honest真实性、Harmless无害性),然后基于这些数据,训练出一个能对回答进行评分预测的奖励模型;接下来用奖励模型给回答进行评分,利用评分作为反馈进行强化学习训练。

提示工程

(Prompt Engineering)

调教AI给出想要的回答:

- 小样本提示

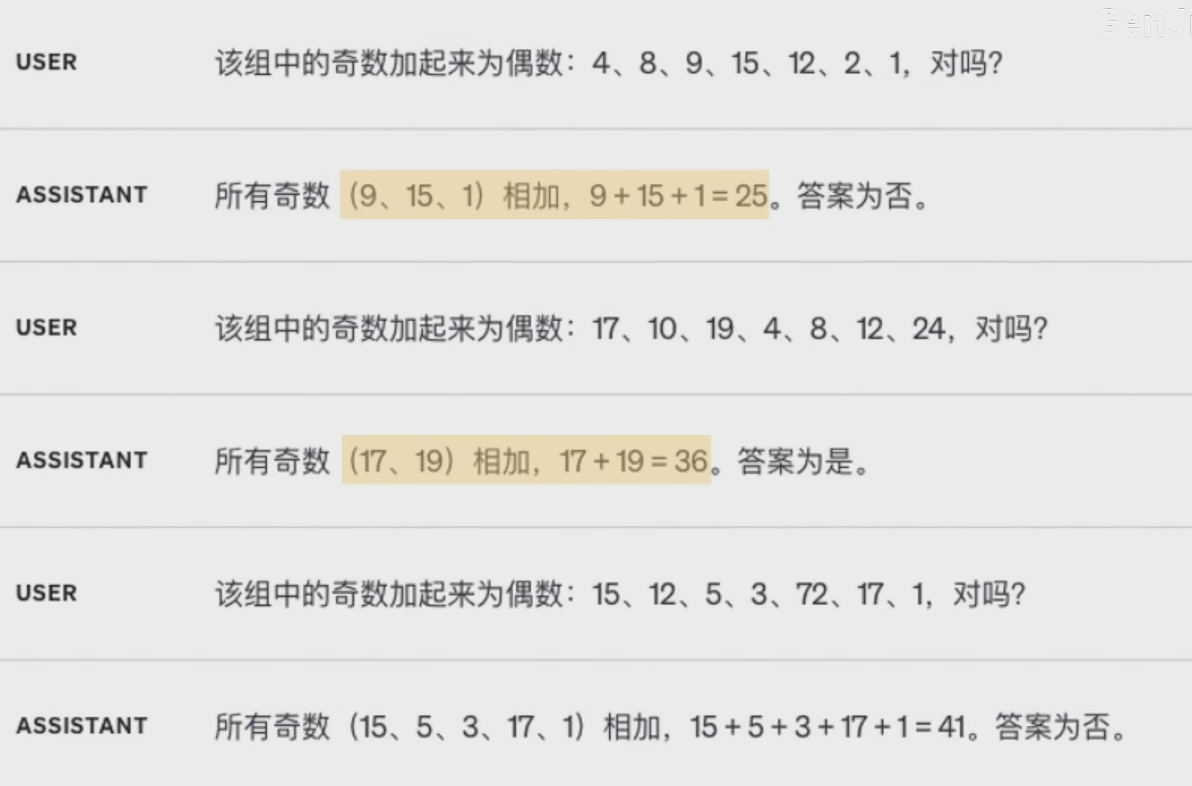

- 思维链

展示中间的推理步骤 -> 针对复杂任务有更大概率得到正确的结果

- 分步骤思考

加上请你分布思考

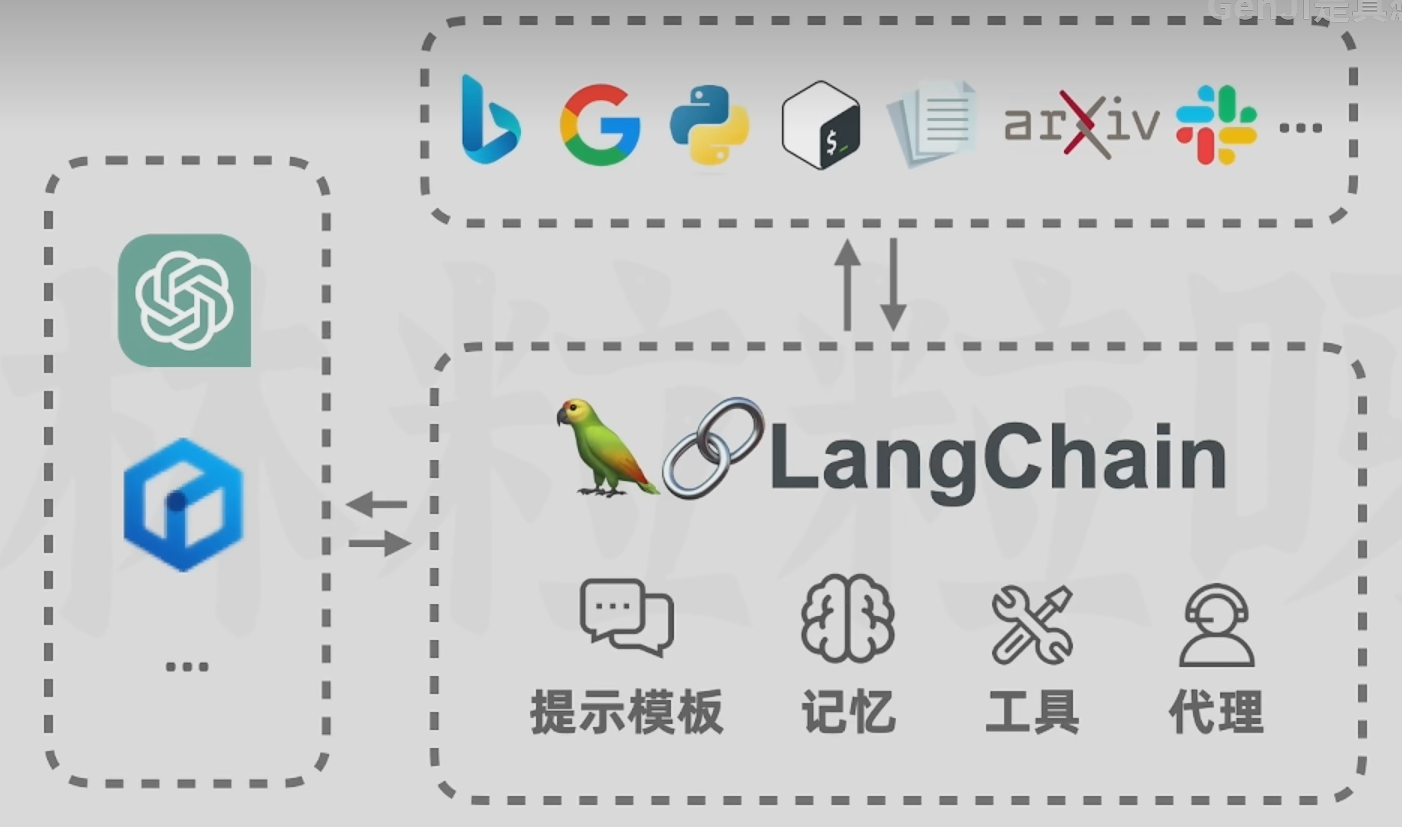

武装GPT

存在问题:

- 编造事实

- 计算不准确

- 数据过时

实现方式:

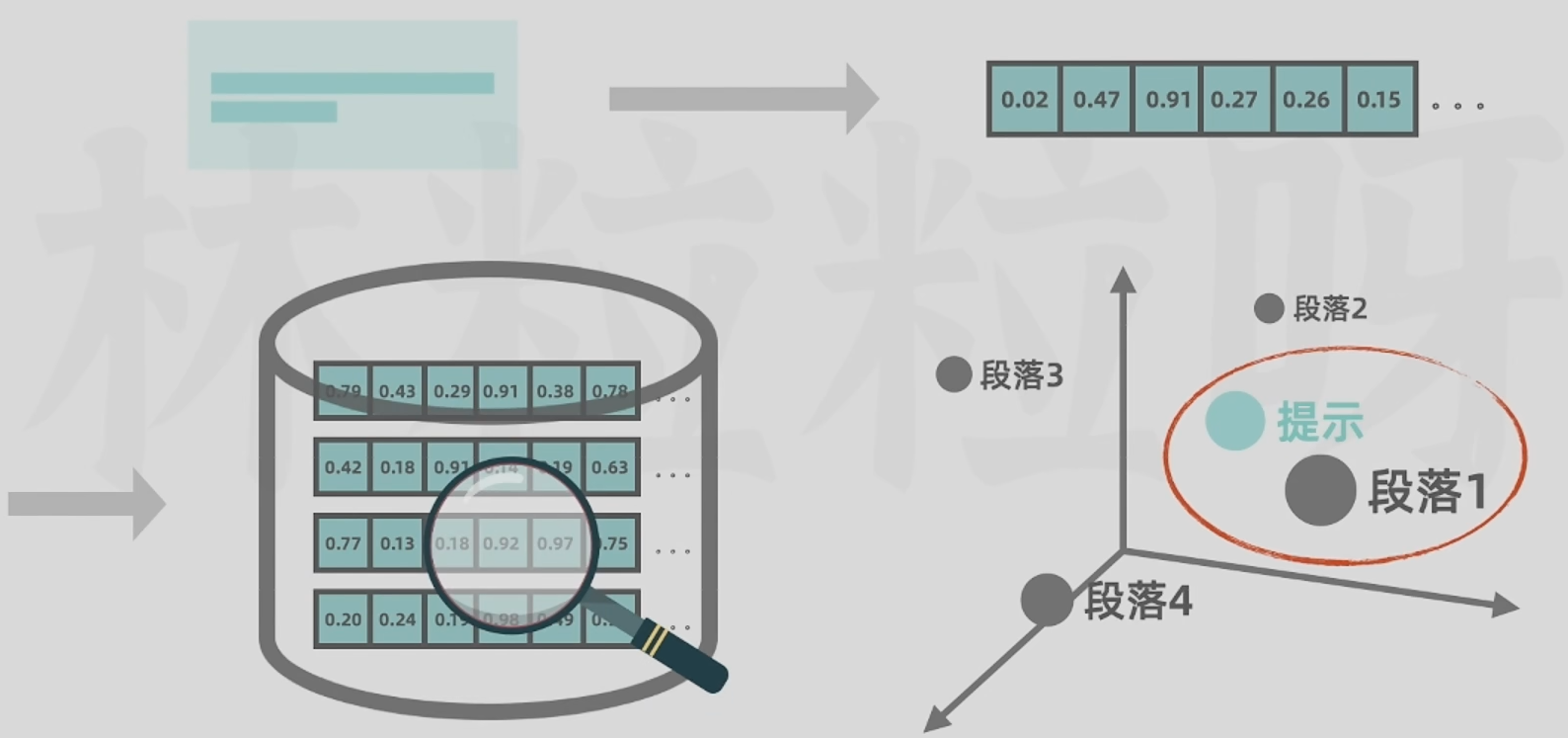

- RAG(Retrieval Augmented Generation,索引增强生成)

输入外部知识文档 -> 转化为向量 -> 储存进向量数据库中

有利于搭建企业知识库或个人知识库

- PAL(Program-Aided Language Models,程序辅助语言模型)

不让AI直接生成计算结果,而是借助其他善于做计算的工具(如Python解释器) -> 生成对应代码,运行,给出结果

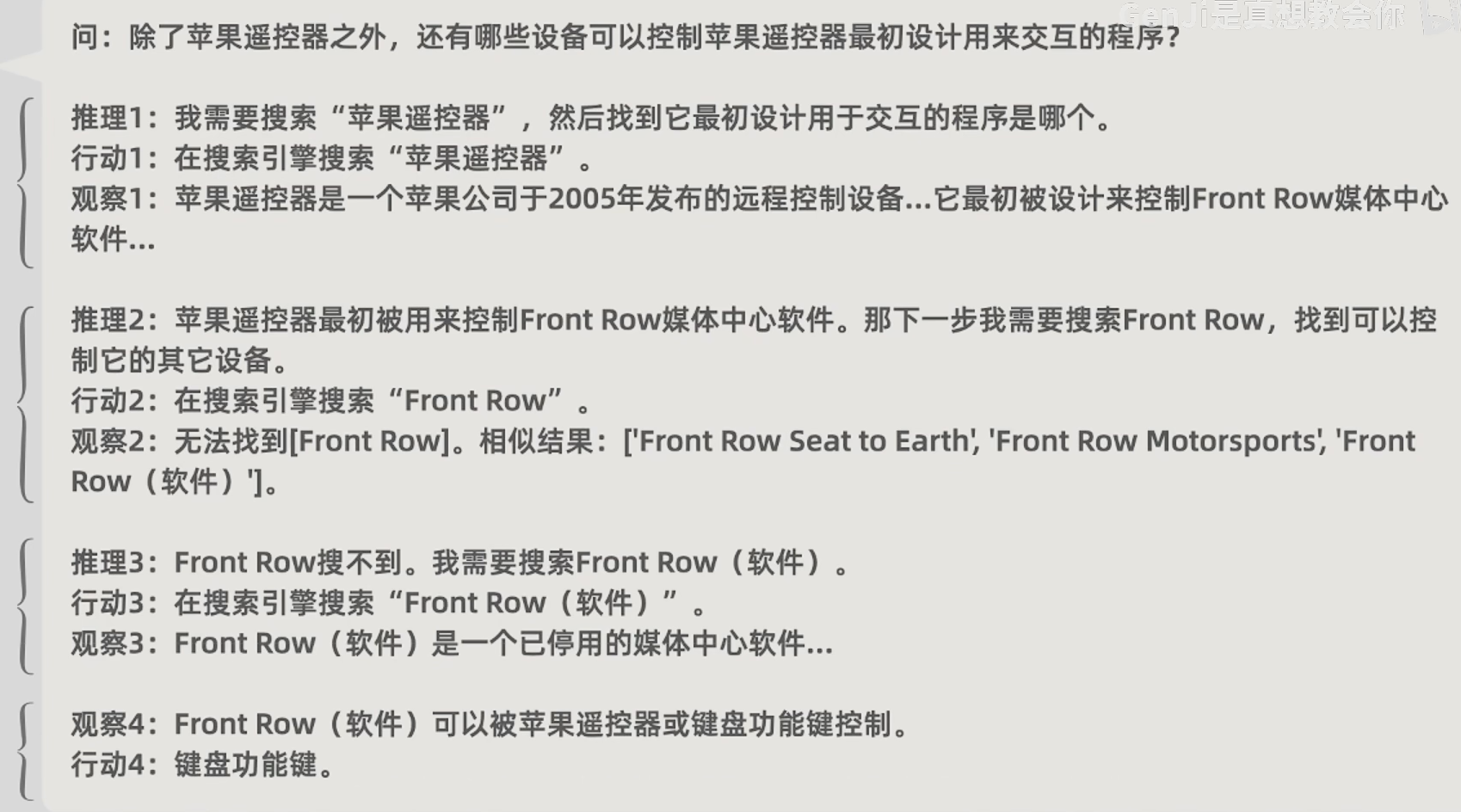

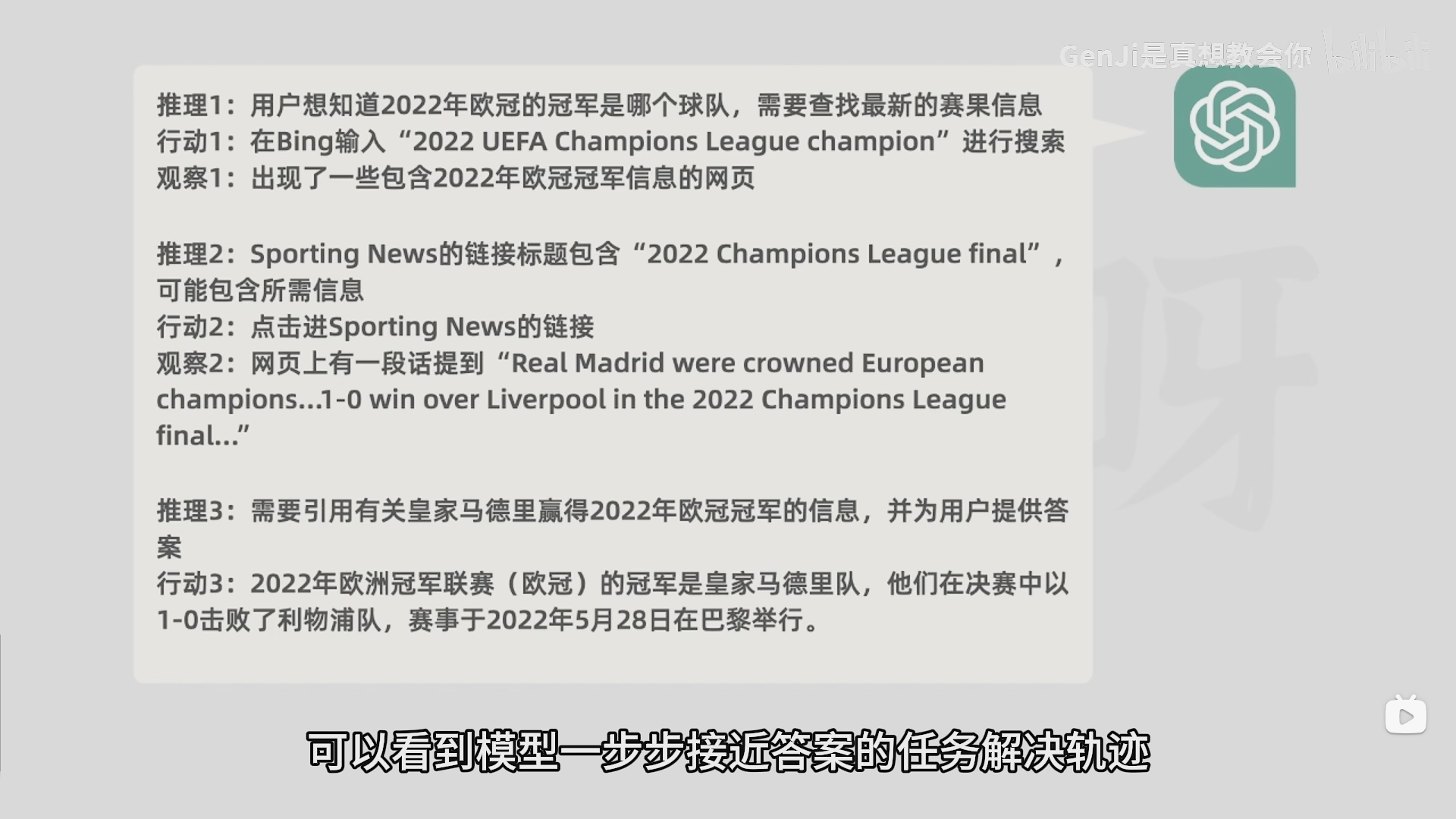

- ReAct(推理行动结合 在语言模型中协同推理与行动)

针对问题把步骤进行拆分,每个步骤要经过推理、行动、观察

推理:针对问题或上一步观察的思考

行动:基于推理与外部环境的一些交互(如搜索浏览器、运行代码等)

观察:对行动得到的结果进行查看

黑匣子 大数据 语言

- 降噪(师兄)

- 语音识别(成熟 难度高 老师经验不算丰富 有一个师兄在做 )

学习的机会

还没有签 500元/月 最终奖励

6月份开始

一个礼拜在线沟通一次

弹性 可以调整 可以取消

入学后不能随便请假

语音识别的模型

黑匣子的录音

几个人在讲 录音转文字识别

难度:

- 背景噪音

- 方言识别

- 主要针对中文

搜一些开源的系统、技术和论文

一个博士生与硕士生在做

商业 最好的 不做开源

跑模型 数据

找开源的数据集 -> 也可以生成

每周四

可以加群 但是相对独立一些